دادههای بزرگ (Big Data) همان دریای اطلاعاتی هستند که هر روز در آن شنا میکنیم! زتا بایتهای وسیعی از دادهها که از کامپیوترها، دستگاههای موبایل و سنسورهای ماشینی جریان مییابند. سازمانها از این دادهها برای تصمیمگیری، بهبود فرآیندها و سیاستها و ایجاد محصولات، خدمات و تجربههای مشتریمحور استفاده میکنند.

دادههای بزرگ به دلیل حجم زیاد، تنوع و پیچیدگیشان، به عنوان “کلان داده” شناخته میشوند. حجم این دادهها معمولاً از ظرفیت پایگاه دادههای سنتی برای جمعآوری، مدیریت و پردازش فراتر میروند. دادههای بزرگ میتوانند از هر منبع یا چیزی روی زمین که قابلیت مانیتورینگ دیجیتالی داشته باشد، به دست آیند. ماهوارههای هواشناسی، دستگاههای اینترنت اشیاء (IoT)، دوربینهای ترافیک، شبکههای اجتماعی و … اینها تنها چند نمونه از منابع دادهای هستند که برای رشد و توسعه و رقابتیتر کردن کسبوکارها، استخراج و تحلیل میشوند.

اهمیت تحلیل دادههای بزرگ

ارزش واقعی دادههای بزرگ به میزانی که شما قادر به تحلیل و درک آن هستید، سنجیده میشود. هوش مصنوعی (AI)، یادگیری ماشین (ML) و فناوریهای نوین پایگاه داده، امکان تجسم و تحلیل دادههای بزرگ را برای استخراج اطلاعات قابل اجرا آن هم در زمان واقعی، فراهم میکنند. تحلیل دادههای بزرگ به شرکتها کمک میکند تا از دادههای خود استفاده کنند، فرصتهای جدید را شناسایی کرده و مدلهای کسبوکار بسازند.

همانطور که جفری مور، نویسنده و تحلیلگر مدیریت، گفته: “بدون تحلیل دادههای بزرگ، شرکتها کور و کر هستند، و مانند آهوانی در بزرگراه اینترنت سرگردان میشوند.”

تکامل دادههای بزرگ

با وجود اینکه امروز غیرقابل تصور به نظر میرسد، کامپیوتر راهنمای آپولو اولین سفینه را با کمتر از ۸۰ کیلوبایت حافظه به ماه برد. از آن زمان، فناوری کامپیوتر و تولید دادهها با نرخ نمایی رشد کرده است. در واقع، ظرفیت فناوری جهانی برای ذخیره دادهها از دهه ۱۹۸۰ تقریباً هر سه سال دو برابر شده است.

فقط بیش از ۵۰ سال پیش زمانی که آپولو ۱۱ به فضا پرتاب شد، مقدار دادههای دیجیتالی تولید شده در سراسر جهان میتوانست روی یک لپتاپ متوسط جا بگیرد. در سال ۲۰۲۰، , Statista برآورد کرد که ۶۴.۲ زتابایت داده ایجاد یا تکرار شده است و “مقدار دادههای دیجیتال ایجاد شده در پنج سال آینده بیشتر از دو برابر مقدار دادههای تولید شده از ابتدای ذخیرهسازی دیجیتال خواهد بود.”

همزمان با پیشرفت روزافزون نرمافزارها و فناوریها، سیستمهای غیر دیجیتال در مقایسه با آنها کمتر قابل استفاده میشوند. دادههای تولید شده و جمعآوری شده به صورت دیجیتال نیاز به سیستمهای مدیریت داده پیشرفتهتری دارند. علاوه بر این، رشد تصاعدی پلتفرمهای رسانههای اجتماعی، فناوریهای تلفنهای هوشمند و دستگاههای متصل به اینترنت اشیا (IoT) به ایجاد عصر دادههای بزرگ (Big Data) کمک کرده است.

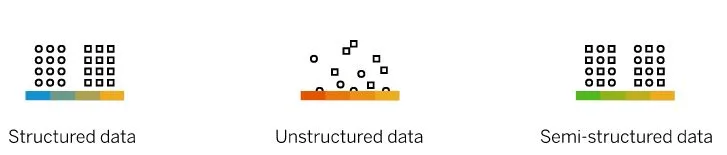

انواع دادههای بزرگ

مجموعه دادهها معمولاً بر اساس ساختار و ساده بودن یا نبودن فرآیند فهرستبندی، به سه نوع تقسیم میشوند.

دادههای ساختاریافته (Structured data)

این نوع داده، سادهترین نوع برای سازماندهی و جستجو هستند. میتواند شامل مواردی مثل دادههای مالی، گزارشهای دستگاهها و جزئیات جمعیتشناسی باشد. یک صفحه اکسل، با ستونها و ردیفهای از پیش تعریف شدهاش، مثالی خوب برای تصور دادههای ساختاریافته است. اجزای آن به راحتی دستهبندی میشوند، که به طراحان و مدیران پایگاه داده اجازه میدهد الگوریتمهای سادهای برای جستجو و تحلیل تعریف کنند.

حتی زمانی که دادههای ساختاریافته حجم عظیمی داشته باشند، لزوماً به عنوان دادههای بزرگ شناخته نمیشوند، زیرا مدیریت دادههای ساختاریافته به تنهایی نسبتاً ساده است و بنابراین معیارهای تعیینکننده دادههای بزرگ را برآورده نمیکند. پایگاههای داده از یک زبان برنامهنویسی به نام زبان پرس و جوی ساختاریافته (SQL) برای مدیریت دادههای ساختاریافته استفاده میکنند. SQL توسط IBM در دهه ۱۹۷۰ توسعه داده شد تا به برنامه نویسان و مهندسان امکان ساخت و مدیریت پایگاههای داده رابطهای را بدهد.

دادههای غیرساختاریافته (Unstructured data)

این دسته از دادهها میتواند شامل پستهای رسانههای اجتماعی، فایلهای صوتی، تصاویر و نظرات مشتریان باشد. این نوع دادهها نمیتوانند به راحتی در پایگاههای داده رابطهای استاندارد با ردیفها و ستونها جای گیرند. تا چندی پیش، شرکتهایی که میخواستند حجم زیادی از دادههای غیرساختاریافته را جستجو، مدیریت یا تحلیل کنند، مجبور بودند از فرآیندهای دستی طاقتفرسا استفاده کنند.

هیچ شکی در مورد ارزش بالقوه تحلیل و درک چنین دادههایی وجود نداشت، اما هزینه انجام این کار اغلب بیش از حد بود و ارزشش را نداشت و با توجه به زمان مورد نیاز، نتایج اغلب قبل از تحویل منسوخ میشدند. دادههای غیرساختاریافته معمولاً در مخازن داده، انبارهای داده و پایگاههای داده NoSQL ذخیره میشوند.

دادههای نیمهساختار یافته

دادههای نیمهساختار یافته ترکیبی از دادههای ساختار یافته و غیرساختار یافته هستند. ایمیلها نمونه خوبی از این نوع دادهها هستند زیرا شامل دادههای غیرساختار یافته در متن پیام و همچنین خواص سازمانی مانند فرستنده، گیرنده، موضوع و تاریخ میشوند. دستگاههایی که از برچسبگذاری جغرافیایی، زمانسنجی یا برچسبهای معنایی استفاده میکنند نیز میتوانند دادههای ساختار یافته را در کنار محتوای غیرساختار یافته ارائه دهند. به عنوان مثال، یک تصویر ناشناس از تلفن هوشمند میتواند به شما بگوید که یک سلفی است و همچنین زمان و مکان گرفته شدن آن را نشان دهد. یک پایگاه داده مدرن با استفاده از فناوری هوش مصنوعی میتواند نه تنها انواع مختلف دادهها را به سرعت شناسایی کند، بلکه الگوریتمهایی را در زمان واقعی تولید کند تا به طور مؤثر دادههای مختلف را مدیریت و تحلیل کند.

منابع دادههای بزرگ

دامنه چیزهایی که داده تولید میکنند با نرخ فوقالعادهای در حال رشد است، از ماهوارههای پهپاد گرفته تا توسترها. اما برای اهداف دستهبندی، منابع داده به طور کلی به سه نوع تقسیم میشوند:

دادههای اجتماعی (Social data)

دادههای اجتماعی توسط نظرات، پستها، تصاویر و ببیشتر از همه از ویدیوهای شبکههای اجتماعی تولید میشوند. با افزایش فراگیری جهانی شبکههای سلولی ۴G و ۵G، تخمین زده میشود که تعداد افرادی که به طور منظم محتوای ویدیویی را در تلفنهای هوشمند خود مشاهده میکنند تا سال ۲۰۲۳ به ۲.۷۲ میلیارد نفر برسد. اگرچه روند استفاده از شبکههای اجتماعی به سرعت و به طور غیرقابل پیشبینی تغییر میکند، اما چیزی که تغییر نمیکند، رشد پایدار این پلتفرمها به عنوان یک تولیدکننده دادههای دیجیتال است.

دادههای ماشینی (Machine data)

دستگاهها و ماشینهای اینترنت اشیا (IoT) با حسگرهایی مجهز شدهاند و قادر به ارسال و دریافت دادههای دیجیتال هستند. حسگرهای اینترنت اشیا به شرکتها کمک میکنند دادههای ماشینی را از دستگاهها، وسایل نقلیه و تجهیزات جمعآوری و پردازش کنند. تعداد چیزهایی که داده تولید میکنند به طور جهانی و به سرعت در حال رشد است، از حسگرهای آب و هوا و ترافیک تا دوربینهای نظارت امنیتی. IDC تخمین میزند که تا سال ۲۰۲۵ بیش از ۴۰ میلیارد دستگاه اینترنت اشیا روی زمین وجود خواهد داشت که تقریباً نیمی از کل دادههای دیجیتال جهان را تولید میکنند.

بیشتر بخوانید:

دادههای تراکنشی (Transactional data)

این دادهها از سریعترین و در حال رشدترین دادههای جهان هستند. اگر همه تراکنشهای خرید و بانکی جهان را یک جا جمع کنید، تصویری از حجم شگفتانگیز دادههای تولید شده به دست میآید. علاوه بر این، دادههای تراکنشی به طور فزایندهای شامل دادههای نیمهساختار یافته هستند، از جمله چیزهایی مانند تصاویر و نظرات، که مدیریت و پردازش آنها را پیچیدهتر میکند.

ویژگیهای دادههای بزرگ

برای اینکه یک مجموعه داده، به عنوان دادههای بزرگ شناخته شود، دادهها باید حداقل دارای پنج ویژگی زیر باشند:

حجم

در حالی که حجم تنها عامل نیست که دادههای بزرگ را “بزرگ” میکند، ولی قطعاً یکی از ویژگیهای اصلی است. برای مدیریت و استفاده کامل از دادههای بزرگ، الگوریتمهای پیشرفته و تحلیلهای مبتنی بر هوش مصنوعی ضروریاند. اما پیش از هر چیز، باید راهی امن و قابل اعتماد برای ذخیرهسازی، سازماندهی و بازیابی ترابایتهای زیادی از دادهها که توسط شرکتهای بزرگ نگهداری میشود، وجود داشته باشد.

سرعت

در گذشته، هر دادهای که تولید میشد باید به صورت دستی وارد سیستمهای پایگاه داده سنتی میشد تا بتوان آن را تحلیل یا بازیابی کرد. امروزه، فناوری دادههای بزرگ، به پایگاههای داده امکان میدهد تا دادهها را در حین تولید، پردازش، تحلیل و پیکربندی کنند؛ گاهی در عرض چند میلیثانیه! برای کسبوکارها، این به معنای استفاده از دادهها در زمان واقعی برای بهرهگیری از فرصتهای مالی، پاسخ به نیازهای مشتری، جلوگیری از تقلب و پاسخگویی به هر فعالیتی است که در آن، سرعت حیاتی است.

تنوع

مجموعه دادههایی که تنها شامل دادههای ساختار یافته هستند، لزوماً دادههای بزرگ نیستند، صرفنظر از حجم آنها. دادههای بزرگ معمولاً ترکیبی از دادههای ساختار یافته، غیرساختار یافته و نیمهساختار یافته هستند. پایگاههای داده و راهحلهای مدیریت داده سنتی انعطافپذیری و دامنه لازم برای مدیریت مجموعه دادههای پیچیده و متنوع که دادههای بزرگ را تشکیل میدهند، ندارند.

صحت

در حالی که فناوری پایگاه داده مدرن به شرکتها امکان میدهد تا مقادیر و انواع عظیمی از دادههای بزرگ را گردآوری کرده و درک کنند، ارزش این دادهها تنها در صورتی است که دقیق، مرتبط و بهموقع باشند. برای پایگاههای داده سنتی که تنها با دادههای ساختار یافته پر میشدند، خطاهای نحوی و تایپی معمولاً مقصر بودند. با دادههای غیرساختار یافته، چالشهای صحت جدیدی به وجود میآید. تعصب انسانی، نویز اجتماعی و مسائل مربوط به منبع دادهها، همگی میتوانند بر کیفیت دادهها تأثیر بگذارند.

ارزش

بدون شک، نتایجی که از تحلیل دادههای بزرگ به دست میآید، اغلب جذاب و غیرمنتظره است. اما برای کسبوکارها، تحلیل دادههای بزرگ باید اطلاعاتی ارائه دهد که به پبشرفت کار و تجارت کمک کند و به مشتریان خود نیز خدمت رسانی بهتری ارائه کنند. فناوریهای مدرن دادههای بزرگ، ظرفیت جمعآوری و بازیابی دادههایی را فراهم میکنند که کارایی را بسیار بالا برده و در تمانی جوانب کار موثر بوده است.

مزایای دادههای بزرگ

راهحلهای مدرن مدیریت دادههای بزرگ به شرکتها اجازه میدهند تا دادههای خام را با سرعت و دقت بیسابقه به اطلاعات مرتبط تبدیل کنند. برخی از مزایای استفاده از دادههای بزرگ در ادامه آمده است:

توسعه محصول و خدمات (Product and service development)

تحلیل دادههای بزرگ به تولید کنندگان اجازه میدهد تا دادههای غیرساختار یافته مانند نظرات مشتریان و گرایشات فرهنگی را تحلیل کرده و به سرعت برای آینده برنامه ریزی کنند.

نگهداری پیشبینیکننده (Predictive maintenance)

در یک نظرسنجی بینالمللی، مککنزی دریافت که تحلیل دادههای بزرگ از ماشینهای مجهز به اینترنت اشیا، هزینههای نگهداری تجهیزات را تا ۴۰ درصد کاهش داده است.

تجربه مشتری (Customer Experience)

در یک نظرسنجی در سال ۲۰۲۰ از مدیران کسبوکارهای جهانی، شرکت گارتنر اعلام کرد شرکتهایی که به صورت فعالتری دادههای تجربه مشتری را جمعآوری میکنند، رشد اقتصادی بیشتری را تجربه کردهاند. تحلیل این دادههای بزرگ به کسبوکارها کمک میکند تا تجربه مشتریان خود از برندشان را بهبود بخشند و شخصیسازی کنند.

علاوه بر دادههای بزرگ، تیمهای تجربه مشتری به طور روز افزون “دادههای ضخیم” (thick data) را نیز مورد توجه قرار میدهند. این اطلاعات کیفی از مشاهدات، احساسات و واکنشهای مشتریان، دادههای بزرگ را تقویت کرده و به شرکتها، درک عمیقتری از مشتریانشان میدهد.

مقاومت و مدیریت ریسک (Resilience and risk management)

همهگیری کووید-۱۹ یک بیدارباش جدی برای بسیاری از مدیران بود، زیرا آنها دریافتند که تجارتشان چقدر در معرض اختلال است. اطلاعات دادههای بزرگ میتواند به شرکتها کمک کند تا ریسکها را پیشبینی کرده و برای غیرمنتظرهها آماده شوند.

صرفهجویی در هزینه و کارایی بیشتر (Cost savings and greater efficiency)

وقتی کسبوکارها، تحلیلهای پیشرفته دادههای بزرگ را در تمام فرایندهای سازمان خود اعمال میکنند، قادر خواهند بود علاوه بر اینکه ناکارآمدیها را شناسایی میکنند، راهحلهای سریع و مؤثر نیز اجرا کنند.

بهبود رقابتپذیری (Improved competitiveness)

اطلاعات حاصل از دادههای بزرگ میتواند به شرکتها کمک کند تا در هزینه ها صرفهجویی کنند، مشتریان را راضی کنند، محصولات بهتری تولید کرده و در تجارتشان نوآوری کنند.

هوش مصنوعی و دادههای بزرگ

مدیریت دادههای بزرگ به سیستمهایی وابسته است که قدرت پردازش و تحلیل مقادیر عظیمی از اطلاعات پیچیده و متنوع را دارند. در این زمینه، دادههای بزرگ و هوش مصنوعی رابطهای متقابل دارند. دادههای بزرگ را نمیتوان بدون هوش مصنوعی سازماندهی و تحلیل نمود و هوش مصنوعی نیز به گستردگی حجم عظیم داده در دادههای بزرگ وابسته است تا تحلیلهایی ارائه دهد که به اندازه کافی قوی، قابل اعتماد و قابل اجرا باشند.

“داده، خون در رگهای هوش مصنوعی است؛ هوش مصنوعی نیاز دارد از دادهها یاد بگیرد تا بتواند وظیفه خود را انجام دهد.”

امروزه تعداد سازمانهایی که علاوه بر دادههای بزرگ، از “دادههای کوچک” نیز برای آموزش الگوریتمهای هوش مصنوعی و یادگیری ماشین خود استفاده میکنند در حال افزایش است. مجموعه دادههای کوچک مانند نظرسنجیهای بازاریابی، جداول، ایمیلها، یادداشتهای جلسات و حتی پستهای فردی در شبکههای اجتماعی، اغلب نادیده گرفته میشوند اما میتوانند حاوی اطلاعات ارزشمندی باشند. در نهایت، هرچه الگوریتمها مواد بیشتری برای یادگیری داشته باشند، خروجی بهتری هم خواهند داشت.

یادگیری ماشین و دادههای بزرگ

الگوریتمهای یادگیری ماشین، دادههای ورودی را تعریف کرده و الگوهایی درون آنها شناسایی میکنند. این اطلاعات به تصمیمگیری و اتوماسیون فرایندها کمک میکند. یادگیری ماشین بر دادههای بزرگ میدرخشد زیرا هرچه مجموعه دادههایی که تحلیل میشوند قویتر باشند، فرصت بیشتری برای سیستم وجود دارد تا یاد بگیرد و به طور مداوم، فرایندهای خود را تکامل و تطبیق دهد.

تکنولوژیهای دادههای بزرگ

معماری دادههای بزرگ (Big Data architecture)

همانند معماری در ساخت و ساز، معماری دادههای بزرگ نقشهای برای ساختار بنیادی نحوه مدیریت و تحلیل دادهها فراهم میکند. معماری دادههای بزرگ فرآیندهای لازم برای مدیریت دادههای بزرگ، در سفرشان از چهار لایه اساسی – از منابع داده، به ذخیرهسازی دادهها، سپس به تحلیل دادههای بزرگ و در نهایت از طریق لایه مصرف که نتایج تحلیل شده به عنوان هوش تجاری ارائه میشوند – را ترسیم میکند.

تحلیل دادههای بزرگ (Big Data analytics)

این فرآیند از طریق استفاده از مدلسازی دادهها و الگوریتمهای خاص به ویژگیهای دادههای بزرگ، امکان تجسم دادههای معنیدار را فراهم میکند. در یک مطالعه عمیق و نظرسنجی از MIT Sloan School of Management، از بیش از ۲۰۰۰ مدیر کسبوکار در مورد تجربه شرکتهایشان در تحلیل دادههای بزرگ پرسیده شد. کسانی که در توسعه استراتژیهای مدیریت دادههای بزرگ خود فعال بودند، نتایج اقتصادی بهتر و کارایی بالاتری به دست آوردند.

دادههای بزرگ و آپاچی هدوپ (Big Data and Apache Hadoop)

تصور کنید ۱۰ سکه ده سنتی را در یک جعبه بزرگ با ۱۰۰ سکه پنج سنتی مخلوط کنید. سپس تصور کنید ۱۰ جعبه کوچکتر، کنار هم، هر کدام با ۱۰ سکه پنج سنتی و یک سکه ده سنتی. در کدام سناریو یافتن سکههای ده سنتی آسانتر خواهد بود؟ هدوپ هم اساساً بر همین اصل کار میکند؛ یک چارچوب متنباز برای مدیریت پردازش دادههای بزرگ توزیعشده در شبکهای از کامپیوترهای متصل به هم. بنابراین به جای استفاده از یک کامپیوتر بزرگ برای ذخیره و پردازش تمام دادهها، هدوپ چندین کامپیوتر را به یک شبکه قابلمقیاس تقریباً بینهایت خوشهبندی میکند و دادهها را به صورت موازی تحلیل میکند. این فرآیند معمولاً از مدل برنامهنویسی به نام MapReduce استفاده میکند که پردازش دادههای بزرگ را با هماهنگی کامپیوترهای توزیعشده مدیریت میکند.

دریاچههای داده (Data lakes)، انبارهای داده (data warehouses) و NoSQL

پایگاههای داده سنتی SQL به سبک صفحهگسترده (spreadsheet) برای ذخیرهسازی دادههای ساختار یافته استفاده میشوند. دادههای بزرگ غیرساختار یافته و نیمهساختار یافته نیاز به پارادایمهای منحصر به فرد ذخیرهسازی و پردازش دارند، زیرا به راحتی قابل فهرستبندی و دستهبندی نیستند.

دریاچههای داده، انبارهای داده و پایگاههای داده NoSQL همگی مخازن دادهای هستند که مجموعه دادههای غیرسنتی را مدیریت میکنند. یک دریاچه داده، حجم وسیعی از دادههای خام است که هنوز پردازش نشده اند. یک انبار داده مکانی برای دادههایی است که قبلاً برای یک هدف خاص پردازش شدهاند. پایگاههای داده NoSQL یک ساختار انعطافپذیر ارائه میدهند که میتواند با انواع دادههای پردازششده تطبیق داده شود. هر یک از این سیستمها دارای نقاط قوت و ضعف خاص خود هستند و بسیاری از کسبوکارها از ترکیبی از این مخازن داده استفاده میکنند تا به بهترین شکل ممکن نیازهای خود را برآورده کنند.

پایگاههای داده در حافظه (In-memory databases)

پایگاههای داده سنتی مبتنی بر دیسک، با فناوریهای SQL و پایگاه دادههای رابطهای توسعه یافتهاند. در حالی که ممکن است بتوانند حجم زیادی از دادههای ساختار یافته را مدیریت کنند، اما به طور کلی برای ذخیره و پردازش دادههای غیرساختار یافته طراحی نشدهاند.

با داشتن پایگاههای داده در حافظه، پردازش و تحلیل به طور کامل در RAM انجام میشود، به جای اینکه دادهها را از یک سیستم مبتنی بر دیسک بازیابی کند. پایگاههای داده در حافظه نیز بر اساس معماریهای توزیعشده ساخته شدهاند. این بدان معناست که آنها میتوانند با استفاده از پردازش موازی، سرعت بسیار بیشتری را نسبت به مدلهای پایگاه داده مبتنی بر دیسک تکگرهای به دست آورند.

دادههای بزرگ چگونه کار میکنند؟

دادههای بزرگ زمانی مفید هستند که تحلیل آنها، اطلاعات مرتبط و با ارزش ارائه دهد و بتواند کسبوکار و یا امور مختلف را بهبود بخشد. سه مرحله اصلی در استفاده از دادههای بزرگ عبارنتد از:

جمعآوری دادههای بزرگ

بسیاری از دادههای بزرگ شامل مجموعههای عظیمی از دادههای غیرساختار یافته هستند که از منابع پراکنده و غیر موثق به سوی سیستمها سرازیر میشوند. پایگاههای داده سنتی مبتنی بر دیسک و مکانیسمهای یکپارچهسازی دادهها به سادگی قادر به مدیریت این حجم از داده نیستند. مدیریت دادههای بزرگ نیازمند پذیرش راهحلهای پایگاه داده در حافظه و نرمافزارهای خاص برای جمعآوری دادههای بزرگ است.

ذخیرهسازی دادههای بزرگ

دادههای بزرگ بسیار حجیم هستند. بسیاری از کسبوکارها راهحلهای ذخیرهسازی در محل برای دادههای موجود خود دارند و امیدوارند با استفاده مجدد از این مخازن برای نیازهای پردازش دادههای بزرگ صرفهجویی کنند. با این حال، دادههای بزرگ زمانی بهترین عملکرد را دارند که از محدودیتهای اندازه و حافظه آزاد باشند. کسبوکارهایی که از ابتدا راهحلهای ذخیرهسازی ابری را در مدلهای دادههای بزرگ خود جای نمیدهند، اغلب پس از چند ماه از این تصمیم خود پشیمان میشوند!

تحلیل دادههای بزرگ

بدون استفاده از فناوریهای هوش مصنوعی و یادگیری ماشین برای تحلیل دادههای بزرگ، به سادگی نمیتوان به پتانسیل کامل آن پی برد. یکی از پنج ویژگی دادههای بزرگ “سرعت” است. برای اینکه اطلاعات حاصل از دادههای بزرگ عملیاتی و ارزشمند باشند، باید به سرعت حاصل شوند. فرآیندهای تحلیلی باید خودبهینهسازی شوند و بتوانند به طور منظم از تجربه یاد بگیرند، نتیجهای که تنها با استفاده از عملکردهای هوش مصنوعی و فناوریهای مدرن پایگاه داده قابل دستیابی است.

کاربردهای دادههای بزرگ

اطلاعات و یادگیری عمیق حاصل از دادههای بزرگ میتواند به تقریباً هر کسبوکار یا صنعتی سود برساند. با این حال، سازمانهای بزرگ با وظایف عملیاتی پیچیده اغلب میتوانند بیشترین و مفیدترین استفاده را از دادههای بزرگ ببرند.

امور مالی

یک مطالعه در سال ۲۰۲۰ نشان میدهد که دادههای بزرگ “نقش مهمی در تغییر بخش خدمات مالی، بهویژه در تجارت و سرمایهگذاری، اصلاحات مالیاتی، کشف و تحقیق تقلب، تحلیل ریسک و اتوماسیون ایفا میکند.” دادههای بزرگ با تحلیل دادهها و بازخورد مشتریان برای به دست آوردن بینشهای ارزشمند به منظور بهبود رضایت و تجربه مشتری، به تحول صنعت مالی کمک کرده است. مجموعه دادههای تراکنشی از سریعترین و بزرگترین مجموعه دادهها در جهان هستند. پذیرش روزافزون راهحلهای پیشرفته مدیریت دادههای بزرگ به بانکها و مؤسسات مالی کمک میکند تا این دادهها را محافظت کرده و از آنها به نحوی استفاده کنند که هم به نفع مشتری و هم کسبوکار باشد.

بهداشت و درمان

تحلیل دادههای بزرگ به پزشکان و متخصصان بهداشت و درمان امکان میدهد تا تشخیصهای مستند و دقیقتری انجام دهند. علاوه بر این، دادههای بزرگ به مدیران بیمارستانها کمک میکند تا فرآیندها را کنترل کنند، ریسکها را مدیریت کرده و هزینههای غیر ضروری را کاهش دهند و بودجه بیمارستان را به مراقبت از بیماران و تحقیق اختصاص دهند.

حمل و نقل و لجستیک

“اثر آمازون” (Amazon Effect) اصطلاحی است که توصیف میکند چگونه آمازون با اجرای طرح تحویل یک روزه مرسولهها، استاندارد جدیدی برای سرعت ارسال ایجاد کرده، بهطوری که اکنون مشتریان این نوع سرعت ارسال را برای هر چیزی که آنلاین سفارش میدهند، انتظار دارند. شرکتهای لجستیک به طور فزایندهای به تحلیل دادههای بزرگ وابسته هستند تا برنامهریزی مسیر، تجمیع بار و اقدامات بهینهسازی مصرف سوخت را انجام دهند.

انرژی و خدمات عمومی

بر اساس آمار اداره کار ایالات متحده، شرکتهای خدمات عمومی بیش از 1.4 میلیارد دلار برای خواندن کنتورها خرج میکنند و معمولاً به کنتورهای آنالوگ و خواندنهای دستی و نادر تکیه میکنند. کنتورهای هوشمند، دادههای دیجیتال را چندین بار در روز ارسال میکنند و با بهرهگیری از تحلیل دادههای بزرگ، این اطلاعات میتوانند به استفاده بهینهتر از انرژی و قیمتگذاری و پیشبینی دقیقتر کمک کنند.

علاوه بر این، زمانی که کارگران میدانی از خواندن کنتورها آزاد شوند، جمعآوری و تحلیل دادهها میتواند به سرعت آنها را به جایی که تعمیرات و یا ارتقاء فوری نیاز است، تخصیص دهد.

پرسشهای متداول

دادههای بزرگ چیست؟

دادههای بزرگ به حجم وسیعی از دادههای ساختاریافته و غیرساختاریافته اشاره دارد که هر ثانیه تولید میشوند. این دادهها شامل مجموعه دادههایی است که به دلیل بزرگی، سرعت یا پیچیدگی زیاد، با نرمافزارهای پردازش دادههای سنتی قابل مدیریت نیستند.

چرا دادههای بزرگ مهم است؟

دادههای بزرگ مهم است زیرا به سازمانها امکان میدهد به درک عمیقتری دست یابند، تصمیمگیریهای آگاهانهتری داشنه باشند و بهرهوری عملیاتی خود را بهبود بخشند. با تحلیل مجموعهدادههای بزرگ، کسبوکارها میتوانند روندها را شناسایی، الگوها را کشف و رفتارهای آینده را پیشبینی کنند.

پنج خصوصیت مهم دادههای بزرگ چیست؟

پنج خصوصیت مهم دادههای بزرگ عبارتند از:

حجم (Volume): مقدار زیاد دادهها.

سرعت (Velocity): سرعت تولید و پردازش دادهها.

تنوع (Variety): انواع مختلف دادهها (ساختیافته، غیرساختیافته، نیمهساختیافته).

صحت (Veracity): کیفیت و دقت دادهها.

ارزش (Value): مفید بودن دادهها برای تصمیمگیری.

چه تکنولوژیهایی در دادههای بزرگ استفاده میشود؟

تکنولوژیهای رایجی که در دادههای بزرگ استفاده میشوند شامل:

هدوپ (Hadoop): یک چارچوب متنباز برای پردازش و ذخیرهسازی مجموعهدادههای بزرگ.

اسپارک (Spark): یک موتور پردازش داده سریع و در حافظه.

پایگاهدادههای NoSQL: مانند MongoDB، کاساندرا (Cassandra) و HBase.

دریاچههای داده (Data lakes): مخازن ذخیرهسازی که مقادیر زیادی داده خام نگهداری میکنند.

دریاچه داده چیست؟

دریاچه داده یک سیستم ذخیرهسازی است که حجم زیادی از دادههای خام را در قالب اصلی خود تا زمان نیاز نگهداری میکند. برخلاف انبارهای داده سنتی، دریاچههای داده میتوانند دادههای ساختیافته، نیمهساختیافته و غیرساختیافته را ذخیره کنند.

تحلیل دادههای بزرگ چه تفاوتی با تحلیل سنتی دارد؟

تحلیل دادههای بزرگ شامل تحلیل مجموعهدادههای بزرگ، متنوع و پیچیده است که ممکن است به سرعت رشد کنند. تحلیل سنتی معمولاً با مجموعه دادههای کوچکتر و ساختاریافتهتر سروکار دارد و اغلب به طرحهای از پیش تعریف شده متکی است.

موارد رایج استفاده از دادههای بزرگ چیست؟

موارد استفاده رایج از دادههای بزرگ شامل:

تحلیل مشتریان: درک رفتار و ترجیحات مشتریان.

نگهداری پیشبینیکننده: پیشبینی خرابی تجهیزات قبل از وقوع.

تشخیص تقلب: شناسایی فعالیتهای متقلبانه به صورت بلادرنگ.

بهداشت و درمان: شخصیسازی برنامههای درمانی و بهبود نتایج بیماران.

بهینهسازی زنجیره تأمین: افزایش بهرهوری و کاهش هزینهها.

چالشهای دادههای بزرگ چیست؟

چالشهای دادههای بزرگ شامل:

کیفیت دادهها: اطمینان از دقت و قابلیت اعتماد دادهها.

یکپارچهسازی دادهها: ترکیب دادهها از منابع مختلف.

حریم خصوصی و امنیت: حفاظت از اطلاعات حساس.

مقیاسپذیری: مدیریت حجم و سرعت افزایش دادهها.

کمبود مهارتها: یافتن متخصصان با تخصص لازم.

پردازش دادههای بلادرنگ چیست؟

پردازش دادههای بلادرنگ شامل تحلیل دادهها به محض تولید برای ارائه اطلاعات و اقدامات فوری است. این امر برای برنامههایی که نیاز به پاسخهای فوری دارند، مانند سیستمهای تشخیص تقلب و تحلیل بازخورد زنده مشتریان، بسیار حیاتی است.