در یک خط تولید، جایی که کارگران با تجهیزات سنگین و خطرناک برای تولید لولههای فولادی کار میکنند، مدیران شرکت، یک تیم از متخصصان یادگیری ماشین را استخدام میکنند تا یک مدل هوش مصنوعی توسعه دهند که به کارگران خط مقدم در اتخاذ تصمیمات ایمن کمک کند، به امید اینکه این مدل بتواند کسبوکارشان را با بهبود کارایی و ایمنی کارگران متحول کند. پس از یک فرآیند توسعه پرهزینه، مدیران مدل پیچیده و با دقت بالای خود را به خط تولید معرفی میکنند و انتظار دارند که شاهد بازگشت سرمایه خود باشند. اما به جای آن، با پذیرش بسیار محدود این مدل توسط کارگران مواجه میشوند. کجای کار اشتباه بوده است؟

این مثال فرضی، نقش حیاتی موجه بودن (Explainable) در دنیای هوش مصنوعی را نشان میدهد. در حالی که مدل در مثال ممکن است ایمن و دقیق بوده باشد، کاربران هدف، به سیستم هوش مصنوعی اعتماد نکردند زیرا نمیدانستند این سیستم چگونه تصمیمگیری میکند. کاربران نهایی حق دارند فرآیندهای تصمیمگیری تحت سیستمهایی که از آنها انتظار میرود استفاده کنند، به ویژه در موقعیتهای حیاتی را درک کنند.

هوش مصنوعی موجه (XAI) ابزاری قدرتمند برای پاسخ به سوالات حیاتی چگونه؟ و چرا؟ درباره سیستمهای هوش مصنوعی است و میتواند برای پرداختن به نگرانیهای اخلاقی و قانونی هم استفاده شود. در نتیجه، پژوهشگران هوش مصنوعی Explainable AI را به عنوان یک ویژگی ضروری از هوش مصنوعی قابل اعتماد دانسته اند و موجه بودن اخیراً توجه زیادی را به خود جلب کرده است. با این حال، با وجود علاقه روز افزون به پژوهشهای Explainable AI و تقاضا برای موجه بودن در حوزههای مختلف، Explainable AI هنوز با محدودیت هایی روبرو است. در این مطلب از سایت نقطه، به شرحی از وضعیت کنونی Explainable AI، شامل نقاط قوت و ضعف این رویکرد میپردازیم.

مبانی هوش مصنوعی موجه

با وجود گستردگی تحقیقات در زمینه موجه بودن، هنوز تعریف دقیقی پیرامون هوش مصنوعی موجه به طور کامل تثبیت نشده است.

این تعریف طیف گستردهای از انواع توضیحات و مخاطبان را در بر میگیرد و اذعان میدارد که تکنیکهای موجه بودن میتوانند به یک سیستم اعمال شوند، نه اینکه همیشه به طور ذاتی در آنها گنجانده شوند.

رهبران و مدیران در حوزههای دانشگاهی، صنعتی و دولتی، فواید موجه بودن را مطالعه کرده و الگوریتمهایی را برای پاسخگویی به طیف گستردهای از زمینهها توسعه دادهاند.

به عنوان مثال، پژوهشگران در حوزه بهداشت و درمان، موجه بودن را به عنوان یک نیاز برای سیستمهای مشاور تصمیمگیری بالینی هوش مصنوعی شناسایی کردهاند، زیرا توانایی تفسیر خروجیهای سیستم تسهیلکننده تصمیمگیری، مشترک بین پزشکان و بیماران است و شفافیت مورد نیاز سیستم را فراهم میکند. در امور مالی، توضیحات سیستمهای هوش مصنوعی برای برآورده کردن الزامات مقرراتی و تجهیز تحلیلگران به اطلاعات لازم برای بررسی تصمیمات پرخطر استفاده میشوند. بنابراین توضیحات میتوانند بسته به زمینه و هدف، به شدت متفاوت باشند.

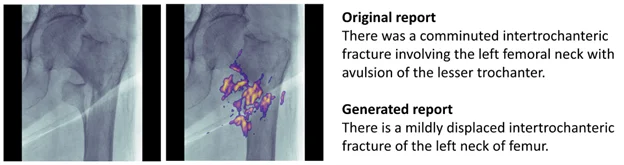

شکل زیر دو توضیح از وضعیت عکس بیمار را شرح میدهد، که یکی توسط پزشک متخصص نوشته شده و دیگری توسط یک مدل هوش مصنوعی. مدل یادگیری ماشین استفاده شده در این مدل، میتواند شکستگی لگن را با استفاده از تصاویر پرتوی ایکس لگن جلویی تشخیص دهد و برای استفاده توسط پزشکان طراحی شده و به راحتی قابل درک و بررسی است.

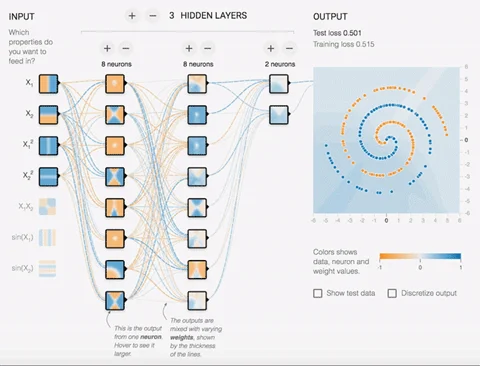

شکل زیر تصویرسازی تکنیکی و تعاملی از لایههای یک شبکه عصبی را نشان میدهد. این ابزار متنباز به کاربران اجازه میدهد تا با معماری یک شبکه عصبی بازی کنند و مشاهده کنند که چگونه نورونهای فردی در طول آموزش تغییر میکنند. توضیحات نقشه حرارتی از ساختارهای مدل یادگیری ماشین میتوانند اطلاعات مهمی درباره عملکرد داخلی مدلهای مبهم به متخصصان یادگیری ماشین ارائه دهند.

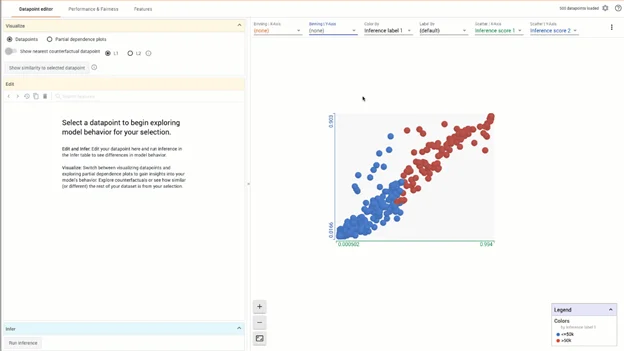

شکل زیر یک نمودار تولید شده توسط ابزار What-If را نشان میدهد که رابطه بین دو نوع امتیاز استنتاجی را به تصویر میکشد. از طریق این تصویرسازی تعاملی، کاربران میتوانند از توضیحات گرافیکی برای تحلیل عملکرد مدل در بخشهای مختلف داده استفاده کنند، تعیین کنند که کدام ویژگیهای ورودی، بیشترین تأثیر را بر تصمیمات مدل دارند و دادههای خود را برای یافتن سوگیریها یا نمونههای غیرعادی بررسی کنند. این نمودارها، علیرغم اینکه بیشتر توسط متخصصان یادگیری ماشین قابل فهم هستند، میتوانند به اطاعات مهمی در مورد عملکرد و عدالت منجر شده و به سهامداران غیر فنی منتقل شوند.

موجه بودن قصد دارد تا به سوالات سهامداران درباره فرآیندهای تصمیمگیری سیستمهای هوش مصنوعی پاسخ دهد. توسعهدهندگان و متخصصان یادگیری ماشین میتوانند از توضیحات برای اطمینان از برآورده شدن نیازهای پروژه مدل یادگیری ماشین و سیستم هوش مصنوعی در حین ساخت، اشکالزدایی و آزمایش استفاده کنند. توضیحات میتوانند به مخاطبان غیر فنی، مانند کاربران نهایی، کمک کنند تا درک بهتری از نحوه کار سیستمهای هوش مصنوعی داشته باشند و سوالات و نگرانیهایشان درباره رفتار سیستم را برطرف سازند. این شفافیت به ساخت اعتماد کمک میکند و از نظارت و قابلیت حسابرسی سیستم پشتیبانی میکند.

تکنیکهای ایجاد هوش مصنوعی موجه در تمام مراحل چرخه عمر یادگیری ماشین توسعه یافته و اعمال شدهاند. روشهایی برای تحلیل دادههایی که برای توسعه مدلها استفاده میشوند (پیشمدلسازی)، گنجاندن قابلیت تفسیر در معماری یک سیستم (مدلسازی موجه)، و تولید توضیحات پسازمدلسازی از رفتار سیستم وجود دارد.

چرا علاقه به هوش مصنوعی موجه در حال افزایش است؟

با پیشرفت هوش مصنوعی، مدلهای مبهم و پیچیدهتری برای حل مشکلات دشوار توسعه یافته و به کار گرفته شدهاند. برخلاف بسیاری از مدلهای قبلی، این مدلها به دلیل ماهیت معماریشان، سختتر قابل درک و نظارت هستند. وقتی چنین مدلهایی شکست میخورند یا به گونهای که انتظار میرود رفتار نمیکنند، ممکن است برای توسعهدهندگان و کاربران نهایی دشوار باشد که دلیل آن را مشخص کنند یا روشهایی را برای حل مشکل تعیین کنند. Explainable AI به نیازهای نوظهور مهندسی هوش مصنوعی با ارائه دانش و بینش در مورد عملکرد داخلی این مدلهای مبهم پاسخ میدهد. نظارت میتواند بهبودهای قابل توجهی در عملکرد به همراه داشته باشد. به عنوان مثال، یک مطالعه توسط IBM نشان میدهد که کاربران پلتفرم Explainable AI آنها به افزایش 15 تا 30 درصدی در دقت مدل و افزایش سود 4.1 تا 15.6 میلیون دلاری دست یافتهاند.

شفافیت به دلیل نگرانیهای اخلاقی پیرامون هوش مصنوعی، اهمیت زیادی دارد. به ویژه این که نقش سیستمهای هوش مصنوعی در زندگی ما پر رنگ تر شده و تصمیمات آنها میتواند پیامدهای قابل توجهی داشته باشد. از نظر تئوری، این سیستمها میتوانند به حذف تعصبات انسانی از فرآیندهای تصمیمگیری که به طور تاریخی مملو از پیشداوری هستند، مانند تعیین وثیقه یا ارزیابی صلاحیت وامهای مسکن کمک کنند.

با این حال، علیرغم تلاش برای حذف تبعیض نژاد از این فرآیندها از طریق هوش مصنوعی، سیستمهای پیادهسازی شده به طور ناخواسته رفتارهای تبعیضآمیز را به دلیل طبیعت مغرض دادههایی که بر اساس آنها آموزش دیدهاند، حفظ کردند. با افزایش اتکا به سیستمهای هوش مصنوعی برای تصمیمگیریهای مهم در دنیای واقعی، ضروری است که این سیستمها بهطور کامل بررسی شده و با استفاده از اصول هوش مصنوعی مسئولانه (RAI) توسعه یابند.

توسعه الزامات قانونی برای پرداختن به نگرانیها و تخلفات اخلاقی همچنان ادامه دارد. به عنوان مثال، مقررات عمومی حفاظت از دادههای اتحادیه اروپا (GDPR) در سال ۲۰۱۶ اظهار میدارد که زمانی که افراد تحت تأثیر تصمیماتی قرار میگیرند که از طریق “پردازش خودکار” اتخاذ شدهاند، حق دارند “اطلاعات معناداری درباره منطق مربوطه” داشته باشند. به همین ترتیب، قانون حفظ حریم خصوصی مصرفکننده کالیفرنیا (CCPA) در سال ۲۰۲۰ تصریح میکند که کاربران حق دارند درباره استنتاجهایی که سیستمهای هوش مصنوعی در مورد آنها انجام دادهاند و دادههایی که برای آن استنتاجها استفاده شدهاند، بدانند. با افزایش تقاضای قانونی برای شفافیت، پژوهشگران و متخصصان، به پیش بردن Explainable AI برای تطابق با الزامات جدید میپردازند.

محدودیتهای کنونی هوش مصنوعی موجه

یکی از موانعی که تحقیقات هوش مصنوعی موجه با آن مواجه است، عدم توافق بر سر تعاریف چندین اصطلاح کلیدی است. تعاریف دقیق هوش مصنوعی موجه در مقالات و زمینههای مختلف متفاوت است. برخی پژوهشگران اصطلاحات موجه بودن و قابلتفسیر بودن را به طور متناوب برای اشاره به مفهوم قابل فهم کردن مدلها و خروجیهای آنها استفاده میکنند. دیگران تفاوتهای مختلفی بین این اصطلاحات قائل هستند. به عنوان مثال، یک منبع دانشگاهی اظهار میکند که موجه بودن به توضیحات پیشین اشاره دارد، در حالی که قابلتفسیر بودن به توضیحات پسین اشاره دارد. تعاریف در حوزه هوش مصنوعی موجه باید تقویت و روشن شوند تا زبان مشترکی برای توصیف و تحقیق در موضوعات Explainable AI فراهم شود.

به همین ترتیب، در حالی که مقالاتی که تکنیکهای جدید Explainable AI را پیشنهاد میدهند فراوان هستند، راهنماییهای واقعی در مورد چگونگی انتخاب، پیادهسازی و آزمایش این توضیحات برای حمایت از نیازهای پروژه کم است. توضیحات نشان دادهاند که درک سیستمهای یادگیری ماشین را برای بسیاری از مخاطبان بهبود میبخشند، اما توانایی آنها در ایجاد اعتماد در میان افرادی که متخصص هوش مصنوعی نیستند، مورد بحث قرار گرفته است. تحقیقات همچنان ادامه دارد که چگونه بهترین استفاده از موجه بودن برای ایجاد اعتماد در میان افراد غیر متخصص در هوش مصنوعی انجام شود؛ توضیحات تعاملی، از جمله توضیحات مبتنی بر سوال و جواب، امیدبخش به نظر میآیند!

پرسشهای متداول

۱. هوش مصنوعی موجه چیست؟

هوش مصنوعی موجه به روشها و تکنیکهایی در هوش مصنوعی اشاره دارد که فرآیندهای تصمیمگیری سیستمهای هوش مصنوعی را شفاف، قابل فهم و قابل تفسیر برای انسانها میسازد. XAI هدف دارد تا بینشی در مورد چگونگی تصمیمگیری مدلهای هوش مصنوعی فراهم کند، به طوری که کاربران بتوانند به این سیستمها اعتماد کرده و آنها را به طور مؤثر مدیریت کنند.

۲. چرا هوش مصنوعی موجه اهمیت دارد؟

هوش مصنوعی موجه از جنبههای مختلفی حیاتی است:

– اعتماد و مسئولیتپذیری: کاربران وقتی که بفهمند تصمیمگیریها چگونه انجام میشود، بیشتر به سیستمهای هوش مصنوعی اعتماد میکنند.

– مطابقت و مقررات: بسیاری از صنایع نیاز به انطباق با مقرراتی دارند که شفافیت در فرآیندهای تصمیمگیری را الزامی میکند.

– اشکالزدایی و بهبود: فهم رفتار مدلها، به تشخیص مشکلات و بهبود عملکرد سیستمهای هوش مصنوعی کمک میکند.

– ملاحظات اخلاقی: اطمینان از اینکه تصمیمهای هوش مصنوعی عادلانه و بدون تعصب هستند، حیاتی است و موجه بودن کمک میکند تا تعصبات شناسایی و کاهش یابند.

۳. تفاوت هوش مصنوعی موجه با هوش مصنوعی سنتی چیست؟

مدلهای سنتی هوش مصنوعی، به خصوص مدلهای پیچیده مانند شبکههای عصبی عمیق، اغلب به عنوان “جعبه سیاه” عمل میکنند، به این معنی که فرآیندهای داخلی آنها شفاف نیست. اما هوش مصنوعی موجه، بر قابل تفسیر ساختن این مدلها تمرکز دارد که با ارائه توضیحاتی برای پیشبینیها یا تصمیمها، اطلاعاتی در مورد فرآیندهای داخلی آنها ارائه میدهد.

۴. چه تکنیکهایی در هوش مصنوعی موجه استفاده میشود؟

چندین تکنیک برای دستیابی به موجه بودن در هوش مصنوعی مورد استفاده قرار میگیرند، از جمله:

– توضیحات مدل-آگنوستیک محلی قابل تفسیر (LIME): تکنیکی که پیشبینیهای فردی را با تقریب مدل به صورت محلی با یک مدل قابل تفسیر توضیح میدهد.

– توضیحات افزایشی شاپلی (SHAP): روشی مبتنی بر نظریه بازیهای همکارانه که خروجی هر مدل یادگیری ماشینی را توضیح میدهد.

– نقشههای برجستگی: توضیحات بصری که ویژگیها یا نواحی مهم در دادههای ورودی که تصمیم مدل را تحت تأثیر قرار میدهند، برجسته میکند.

– درختهای تصمیم: مدلهای ساده و قابل تفسیر که توضیحات سلسله مراتبی و شفافی از تصمیمها ارائه میدهند.

۵. هوش مصنوعی موجه با چه چالشهایی رو به رو است؟

برخی از چالشهای کلیدی شامل موارد زیر میشوند:

– پیچیدگی در مقابل قابل تفسیر بودن: توازن بین پیچیدگی مدلها و نیاز به قابل تفسیر بودن میتواند دشوار باشد.

– مقیاسپذیری: اطمینان از اینکه روشهای توضیحپذیری برای دادهها و مدلهای بزرگ و واقعی مقیاسپذیر و قابل استفاده هستند.

– دقت توضیحات: ارائه توضیحاتی که هم دقیق و هم برای کاربران معنادار باشند.

– نیازهای متنوع ذینفعان: ذینفعان مختلف (مثلاً دانشمندان داده، کاربران نهایی، ناظران) ممکن است نیاز به انواع مختلفی از توضیحات داشته باشند.

۶. هوش مصنوعی موجه در کدام صنایع اهمیت ویژه دارد؟

هوش مصنوعی موجه در صنایعی که تصمیمها تأثیرات قابل توجهی بر افراد یا جامعه دارند، حیاتی است، از جمله:

– بهداشت و درمان: برای سیستمهای تشخیصی و توصیههای درمانی.

– مالی: برای امتیازدهی اعتباری، تشخیص تقلب و تصمیمات سرمایهگذاری.

– حقوقی: در پیشبینی نتایج پروندهها و ارزیابیهای ریسک.

– خودروسازی: برای سیستمهای رانندگی خودکار.

– دولت و بخش عمومی